适用于组织的 Windows Backup 首次登录还原体验现已发布

适用于组织的 Windows Backup 首次登录还原体验现已发布

2026年2月24日微软公布首次登录还原体验已作为 Windows Backup for Organizations 的一部分正式提供。首次登录还原体验即允许组织用户在完成 OOBE 后首次登录 Windows 时可以再次选择是否要从备份恢复设备。如果你对 Windows Backup for Organizations 还感到陌生,建议先阅读以下几篇日志:

默认情况下,当 IT 启用了 Windows Backup for Organizations 后,用户可以在自己的设备上使用 Windows Backup 对当前系统进行备份,当重装系统或使用新设备时,在 OOBE 完成组织账户验证后,便会提示选择还原电脑,可将之前的备份信息恢复到当前设备上。在早期,用户只有在 OOBE 阶段才能进行这个恢复选择,但现在用户即使在 OOBE 错过了恢复操作,也可以在首次登录 Windows 桌面时根据提示再次选择是否执行恢复,这一体验将会极大的方便用户。

需要注意,首次登录期间的还原要求如下:

- Windows 11 24H2 26100.7922 或更高版本

- Windows 11 25H2 26200.7922 或更高版本

- 设备已完成注册

- 注册后,用户首次登录

- 用户至少有一个备份配置文件

- 必须 Microsoft Entra 联接或 Microsoft Entra 混合联接

推荐官方文档:

Windows Server vNext 已支持 ReFS Boot

Windows Server vNext 已支持 ReFS Boot

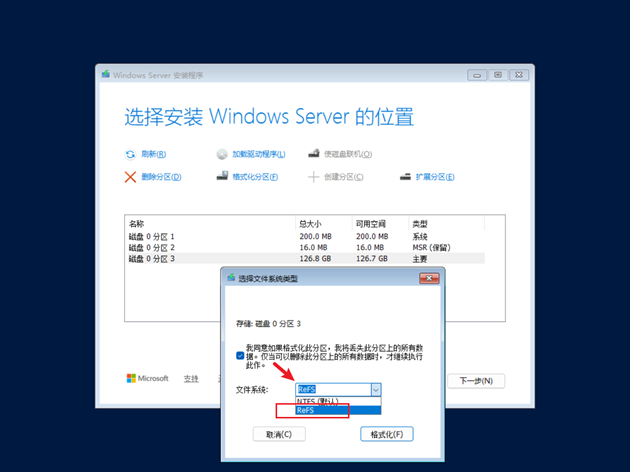

Windows Server Insider 宣布 Windows Server vNext Preview Build 29531 版本(2026年2月11日)开始支持 ReFS 启动。这意味着当我们使用 Windows Server 安装源进行全新系统安装时,可以将系统分区格式化为 ReFS!需要注意,在进行安装时 ReFS 不是默认选项,所以需要创建分区后单独将 OS 分区格式化为 ReFS。如下图所示:

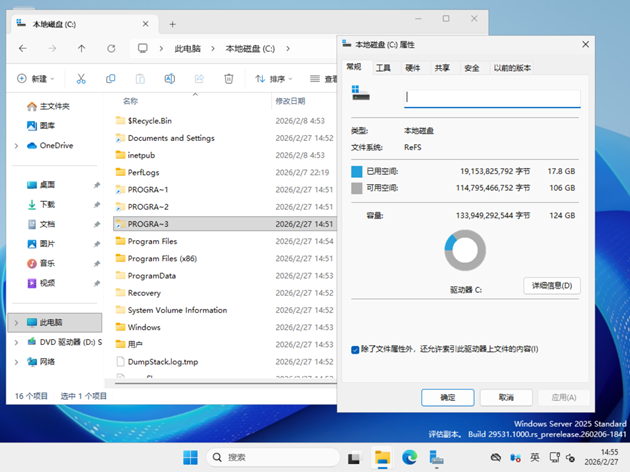

完成安装后要对分区进行验证,可以进入分区属性进行查看,如下图所示。也可以使用命令行 “fsutil fsinfo volumeinfo c:”检查 File System Name 的值是否为 ReFS。

提到 ReFS 可能一些用户会感到陌生,它是由微软开发的一种现代文件系统,提升了数据保护和系统性能,特别适合那些对数据可用性、可扩展性和完整性要求高的使用场景。其主要优势表现在以下几个方面:

- 完整性流:ReFS 将校验和用于元数据和文件数据,能够可靠检测到损坏。

- 存储空间集成:当与镜像或奇偶校验空间结合使用时,ReFS 可以通过存储空间提供的备用副本自动修复检测到的损坏。修复过程将本地化到损坏区域且联机执行,不会发生卷停机时间。

- 数据恢复:如果卷损坏且损坏的数据没有备用副本存在,ReFS 将从命名空间中删除损坏的数据。ReFS 在处理大多数不可更正的损坏时可将卷保持在联机状态,只有极少数情况下,ReFS 需要将卷保持在脱机状态。

- 主动错误更正:除了在读取和写入之前验证数据外,ReFS 还会引入数据完整性扫描程序,称为清理器。此清理器会定期扫描卷,从而识别潜在损坏,然后主动触发损坏数据的修复。

ReFS 还具有性能敏感和虚拟化工作负载的功能。实时层优化、块克隆和稀疏有效数据长度这些不断发展的功能旨在支持动态与多种工作负载。在镜像加速奇偶校验中,ReFS会将卷划分为两个逻辑存储组,称为层。ReFS 会使用它们为热数据提供快速存储,以及为冷数据提供节省空间的存储。通过块克隆加速复制操作,能够实现快速且底影响的 VM 检查点合并操作。稀疏 VDL 能够让 ReFS 快速将文件清零,从而把创建固定虚拟硬盘所需的时间从几十分钟减少到仅仅几秒的时间。

ReFS 与 NTFS 的比较:

功能 | ReFS | NTFS |

最大文件名称长度 | 255 Unicode | 255 Unicode |

最大路径名称长度 | 32K Unicode | 32K Unicode |

文件大小上限 | 35PB | 256TB |

最大卷大小 | 35PB | 256TB |

块克隆 | √ | × |

稀疏 VDL | √ | × |

镜像加速奇偶校验 | √ | × |

文件级快照 | √ | × |

Transactions | × | √ |

对象 ID | × | √ |

ODX | × | √ |

短名称 | × | √ |

磁盘配额 | × | √ |

在可移动媒体上受支持 | × | √ |

可启动 | × | √ |

收缩 | × | √ |

推荐官方文档: Resilient File System (ReFS) overview | Microsoft Learn

下载:Windows Server Insider Preview

评估密钥:

- 标准版:MFY9F-XBN2F-TYFMP-CCV49-RMYVH

- 数据中心版:2KNJJ-33Y9H-2GXGX-KMQWH-G6H67

HOWTO: 通过 Intune 修正脚本来监视安全启动证书状态

HOWTO: 通过 Intune 修正脚本来监视安全启动证书状态

去年11月份 gOxiA 分享了“HOWTO: 升级 Secure Boot 证书解决 2026年到期问题”的日志,看起来很多 IT 都在关注这个事情。如果当前组织正计划开始实施安全证书的更新,并且已经在基于 Intune 管理,那么强烈建议考虑通过 Intune 修正脚本来监视安全启动证书的状态。

微软官方给出了一套方案,使用一个 PowerShell 脚本来收集安全启动和证书状态,将这些清单数据输出为 JSON 字符串,并将其报告回 Intune,这样 IT 人员便可直观了解到每个设备的安全启动证书的状态信息,来采取对应的计划或措施。微软提供的脚本只用来收集对应信息,不会做任何变更动作,可放心使用。

从脚本内容可见会从以下源读取信息:

- 注册表 - HKLM\SYSTEM\CurrentControlSet\Control\SecureBoot,获取安全启动证书更新状态、设备属性等信息。

- WMI/CIM - 获取 OS 版本、上次启动时间和主板硬件信息。

- 事件日志 - 收集事件ID 为 1801 和 1808 的系统事件,这两个 ID 事件为安全启动更新事件。

相关信息会转换为 JSON 字符串输出显示在 Intune 门户中,具体位置是“设备 - 脚本和修正”在列表中找到刚才添加的脚本条目,进入后在列中启用“修正前检测输出”,具体如下图所示,就能看到收集到的设备安全启动的相关信息。

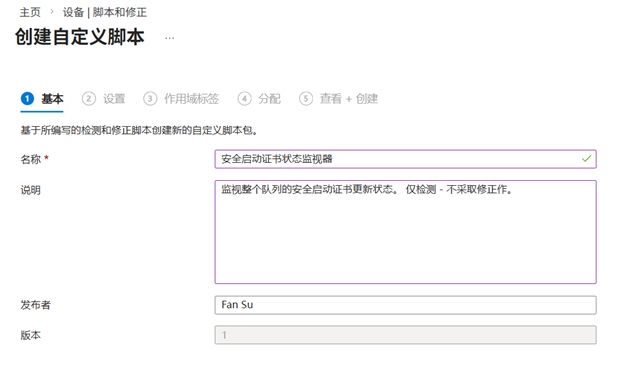

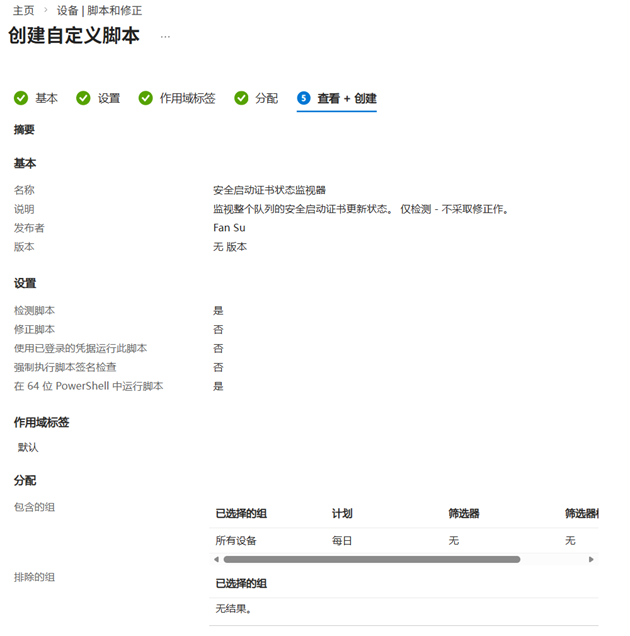

要创建这个修正也很简单,进入 Intune 管理中心 - 设备 - 脚本和修正,添加脚本。然后定义个名称,并根据需要添加说明。

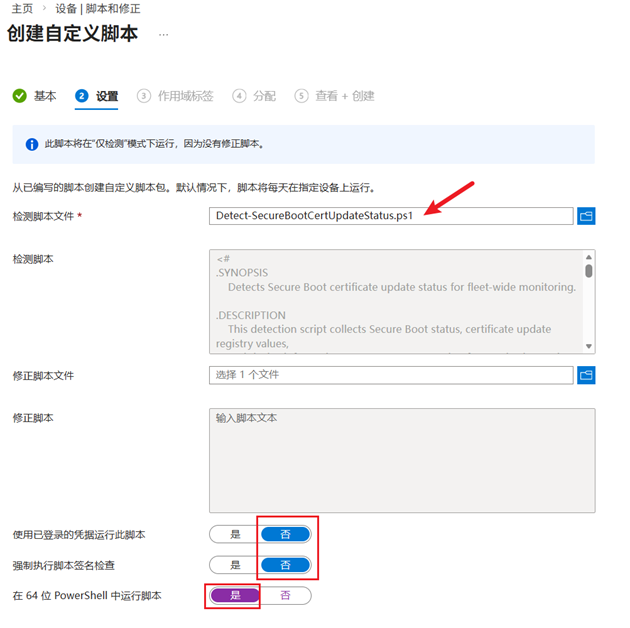

然后,上传 ps1 脚本文件,并确保“使用已登录的凭据运行此脚本”和“强制执行脚本签名检查”为“否”,并将“在 64 位 PowerShell 中运行脚本”设为“是”。

根据需要分配要收集数据额组,并配置一个计划,建议为每日执行。

在审阅界面确认配置无误便可创建。

需要注意的是,如果进入脚本和修正后无法在修正中添加脚本,则需要检查是否允许 Windows 许可证验证,为此 IT 管理员需要进入 Intune 租户管理 - 连接器和令牌中找到 Windows 数据选项来启用该配置。

推荐官方文档:

Monitoring Secure Boot certificate status with Microsoft Intune remediations | Microsoft Support

Microsoft Intune Remediations | Microsoft Learn

Enable Windows diagnostic data and license verification | Microsoft Learn